Disaster recovery en CEPH

En la actualidad en las arquitecturas cloud se está utilizando el SDS que significa Software Definied Storage, la idea principal de estos sistemas es tratar el almacenamiento como si fuese software independientemente del hardware físico que tengamos. Este tipo de sistemas facilita mucho a las empresas el cambio de hardware, por uno de mejores prestaciones, reduciendo el tiempo de migraciones a cero. Algunos ejemplos de SDS son; CEPH, Swift, pNFS, SDDC by VMWare,…

Uno de los principales sistemas de almacenamiento definido por software es CEPH. Se caracteriza por ser un proyecto Opensource con gran relevancia en la actualidad debido a que es uno de los principales componentes utilizado para la instalación de Openstack bajo el módulo de Cinder. CEPH permite implementar diferentes tipos de almacenamiento (bloque, objecto, fichero) y además lo hace de forma distribuida evitando tener un único punto de fallo.

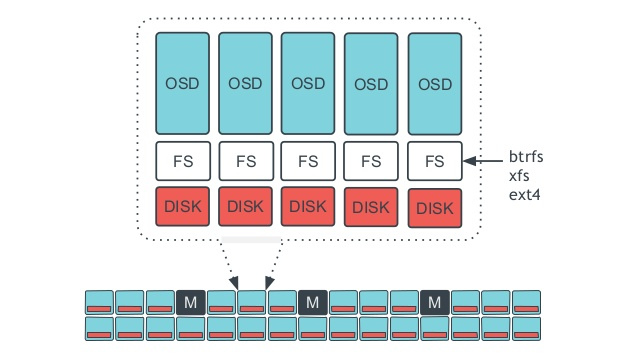

CEPH esta formado por diferentes componentes que son los que en su conjunto le dan toda su versatibilidad. En primer lugar nos encontramos los OSD (Object Storage Daemon) y que se encarga de almacenar todos los datos, gestiona la replicación y realiza el balanceo, en segundo lugar nos encontramos los nodos de monitorización (MON) que tienen como objectivo vigilar el cluster y que es un elemento esencias para la coordinación de todos los servicios, en tercer lugar tenemos los servidores de metadatos (MDS) que almacenta los metadatos del Ceph Filesystem y elimina carga al cluster y por último tenemos los managers (MGR) que se encargan de parte de la monitorización y gestion del espacio asi como los frontales web y APIs de la plataforma. Por su forma de trabajar se necesitan al menos 3 nodos de cada uno de los elementos esenciales (OSD, MON) para poder disponer de un entorno productivo con HA.

Este sistemas por su arquitectura no necesita backups, ya que al disponer de minimo 3 nodos en réplica que podemos distribuir en diferentes zonas geográficas siempre vamos tener minimo una copia balanceada en tiempo real disponible desde nuestro cliente, ya sea desde una máquina virtual o desde un almacenamiento a nivel de objecto.

Sin embargo si aun así queremos disponer de copias de seguridad para poder disponer de un disaster recovery total, a continuación os dejo un script que nos permite descargarnos nuestros ficheros en RAW del Pool “volumes” de nuestro CEPH y almacenarlo en un disco o sistema de ficheros compartido.

|

|

Cabe mencionar que este script está directamente orientado a una arquitectura de Openstack + Ceph que ha sido desplegada con Kolla.